前些天发现了一个巨牛的人工智能学习网站,通俗易懂,风趣幽默,忍不住给大家分享一下。点击跳转到网站:https://www.captainai.net/dongkelun

前言

自己有个需求,如题,需要获取HDFS路径下所有的文件名,然后根据文件名用Spark进行后续操作。想了一下用Spark好像不太容易获取到,还要递归的去获取子目录下的文件名,于是查了一下,最后用Hadoop的API搞定,这里记录下,方便以后会用到。

1、数据

测试路径:/tmp/dkl,全路径名hdfs://ambari.master.com:8020/tmp/dkl

用hadoop的命令查看一下,该路径下都有哪些文件和文件夹1

hadoop fs -ls /tmp/dkl

附图:

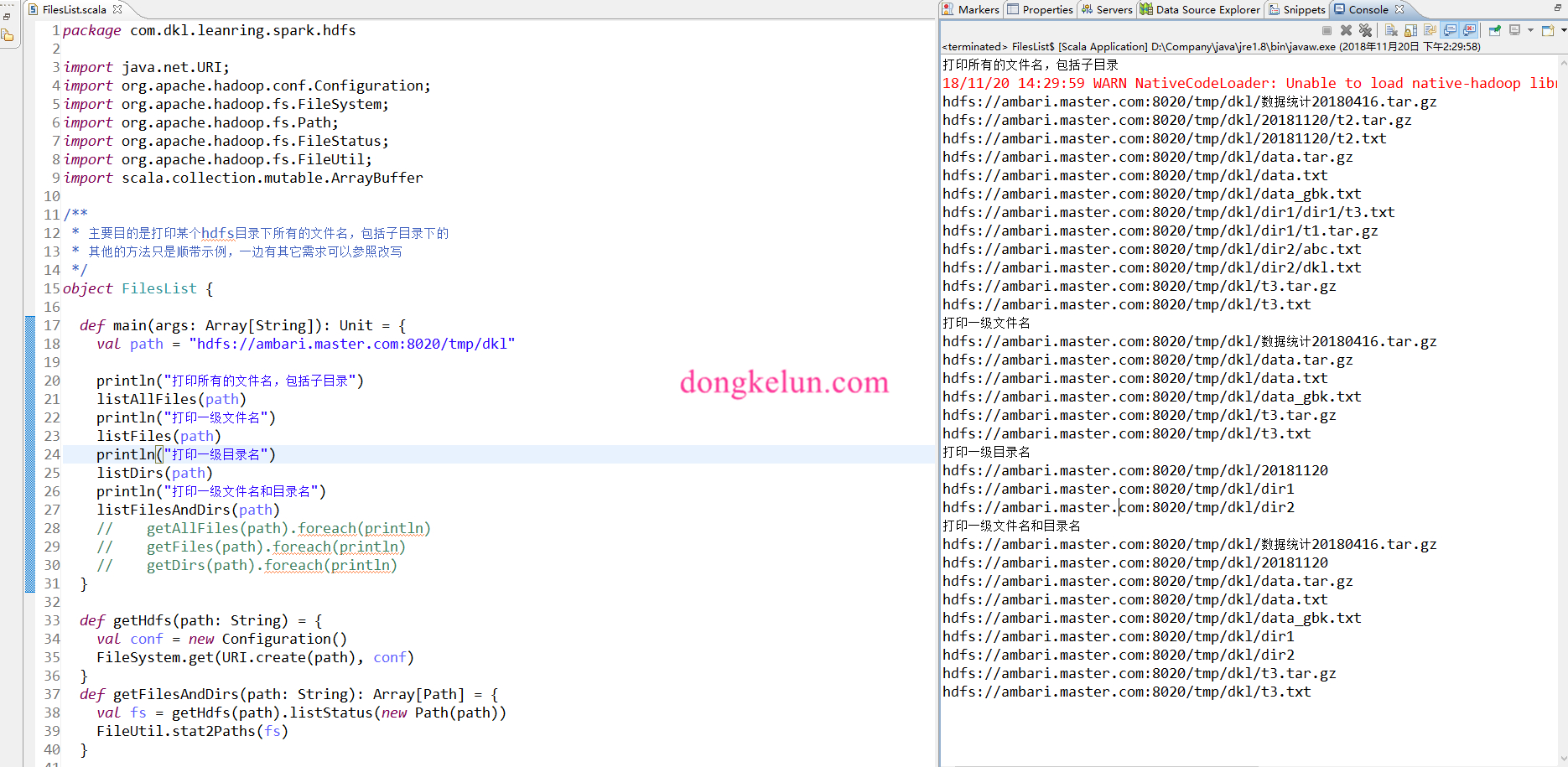

2、完整代码

不多做解释了,直接看代码和结果吧(稍微封装了一下,有其它需求可以参考改写)

1 | package com.dkl.leanring.spark.hdfs |

3、结果