前些天发现了一个巨牛的人工智能学习网站,通俗易懂,风趣幽默,忍不住给大家分享一下。点击跳转到网站:https://www.captainai.net/dongkelun

前言

Spark有多种方式设置日志级别,这次主要记录一下如何在spark-submit设置Spark的日志级别。

1、需求

因为Spark的日志级别默认为INFO(log4j.rootCategory=INFO, console),这样在运行程序的时候有很多我不需要的日志信息都打印出来了,看起来比较乱,比较烦,抓不住重点,而我只想把warn和error打印出来。

之前在测试环境或者在eclipse我是通过其他几种方式(下面会介绍)设置的,但是在生产环境下不允许我修改集群的配置文件(不是我负责~),而在代码里设置日志级别却不生效(原因还没找到),最后通过spark-submit里设置日志级别搞定的。

2、spark-submit 设置

1 | spark-submit --conf "spark.driver.extraJavaOptions=-Dlog4j.configuration=file:log4j.properties" |

其中log4j.properties为我将本地的日志文件,拷贝到执行spark-submit的机器上

参考:https://blog.csdn.net/xueba207/article/details/50436684

3、其他几种设置方法

3.1 修改集群的配置文件

1 | cd $SPARK_HOME/conf |

将log4j.rootCategory=INFO, console改为log4j.rootCategory=WARN, console

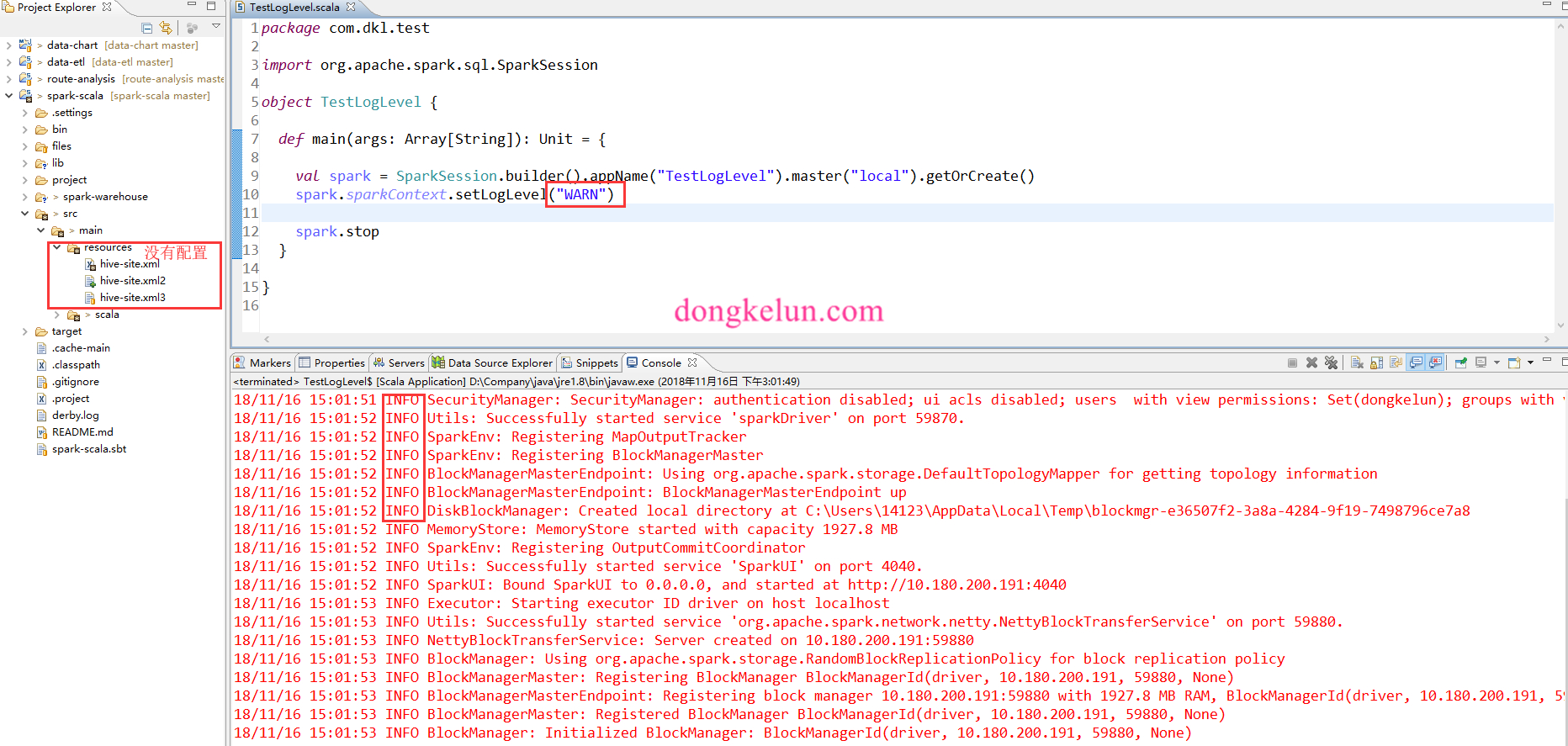

3.2 在Eclipse里设置

将log4j.properties放在项目的src/main/resources即可