前些天发现了一个巨牛的人工智能学习网站,通俗易懂,风趣幽默,忍不住给大家分享一下。点击跳转到网站:https://www.captainai.net/dongkelun

前言

由于现在要用spark,而学习spark会和hdfs和hive打交道,之前在公司服务器配的分布式集群,离开公司之后,自己就不能用了,后来用ambari搭的三台虚拟机的集群太卡了,所以就上网查了一下hadoop+hive的单机部署,以便自己能进行简单的学习,这里记录一下,本来想把hadoop和hive的放在一起写,由于太多,就分成两篇写了。

1、首先安装配置jdk(我安装的1.8)

2、下载hadoop

下载地址:http://mirror.bit.edu.cn/apache/hadoop/common/,我下载的是hadoop-2.7.5.tar.gz

(由于我之前用的2.7.1是几年前下载保存在本地的,现在发现之前在配置spark那篇写的那个hadoop下载地址较慢,所以改成这个地址)

3、解压到/opt目录下(目录根据自己习惯)

1 | tar -zxvf hadoop-2.7.5.tar.gz -C /opt/ |

4、配置hadoop环境变量

1 | vim /etc/profile |

1 | export HADOOP_HOME=/opt/hadoop-2.7.5 |

1 | source /etc/profile |

5、配置hadoop

5.1 配置hadoop-env.sh

1 | vim /opt/hadoop-2.7.5/etc/hadoop/hadoop-env.sh |

找到# The java implementation to use.将其下面的一行改为:1

export JAVA_HOME=/opt/jdk1.8.0_45

5.2 配置core-site.xml (5.2和5.3中配置文件里的文件路径和端口随自己习惯配置)

其中的IP:192.168.44.128为虚拟机ip,不能设置为localhost,如果用localhost,后面在windows上用saprk连接服务器(虚拟机)上的hive会报异常(win读取的配置也是localhost,这样localhost就为win本地ip了~也可以给ip加个映射,不过因为单机的我就没加)。1

vim /opt/hadoop-2.7.5/etc/hadoop/core-site.xml

1 | <configuration> |

5.3 配置hdfs-site.xml

1 | vim /opt/hadoop-2.7.5/etc/hadoop/hdfs-site.xml |

1 | <configuration> |

6、SSH免密码登录

7、启动与停止

第一次启动hdfs需要格式化:1

2cd /opt/hadoop-2.7.5

./bin/hdfs namenode -format

Re-format filesystem in Storage Directory /opt/hadoop-2.7.5/tmp/dfs/name ? (Y or N)

输入:Y

(出现询问输入Y or N,全部输Y即可)

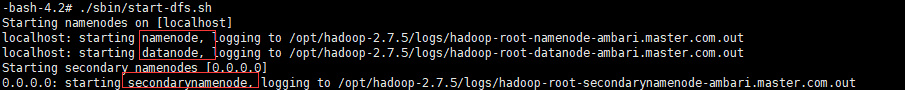

启动:1

./sbin/start-dfs.sh

停止:1

./sbin/stop-dfs.sh

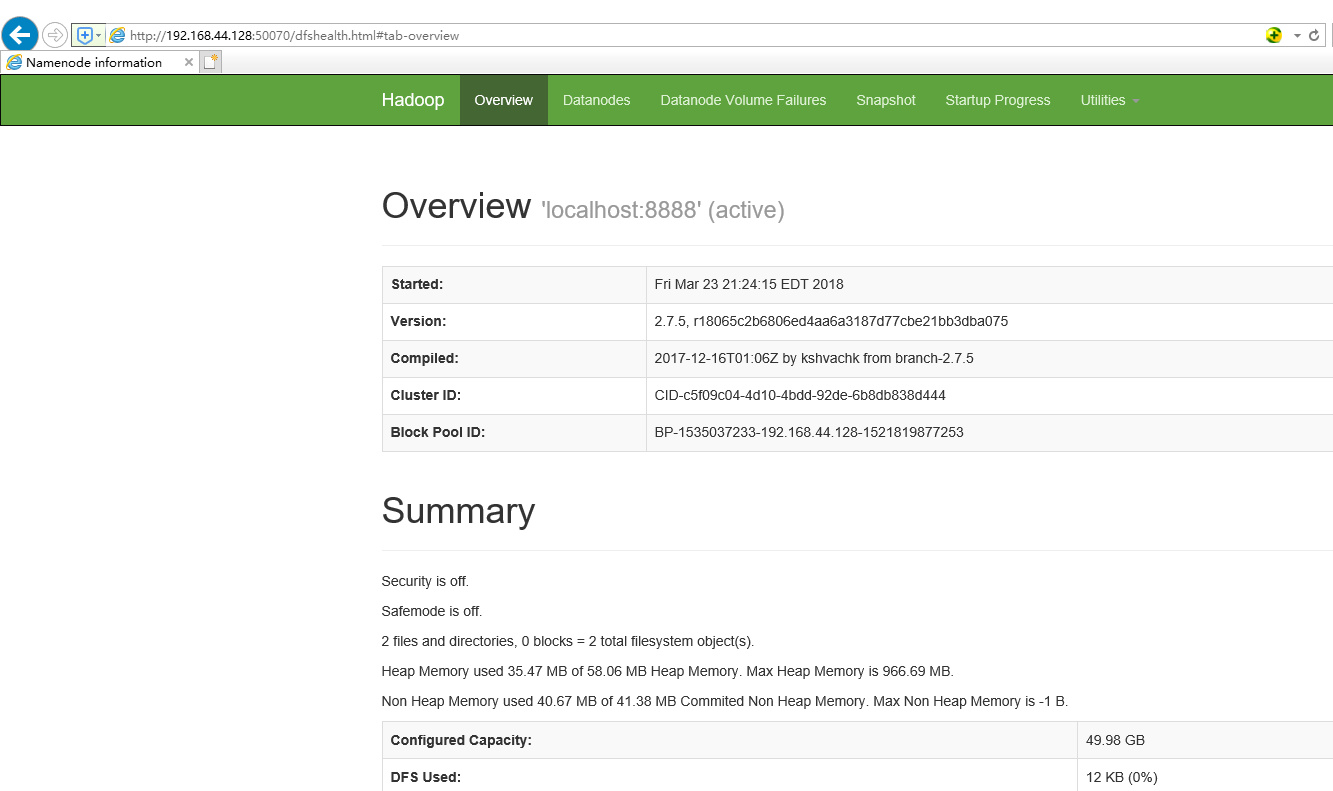

验证,浏览器输入:http://192.168.44.128:50070

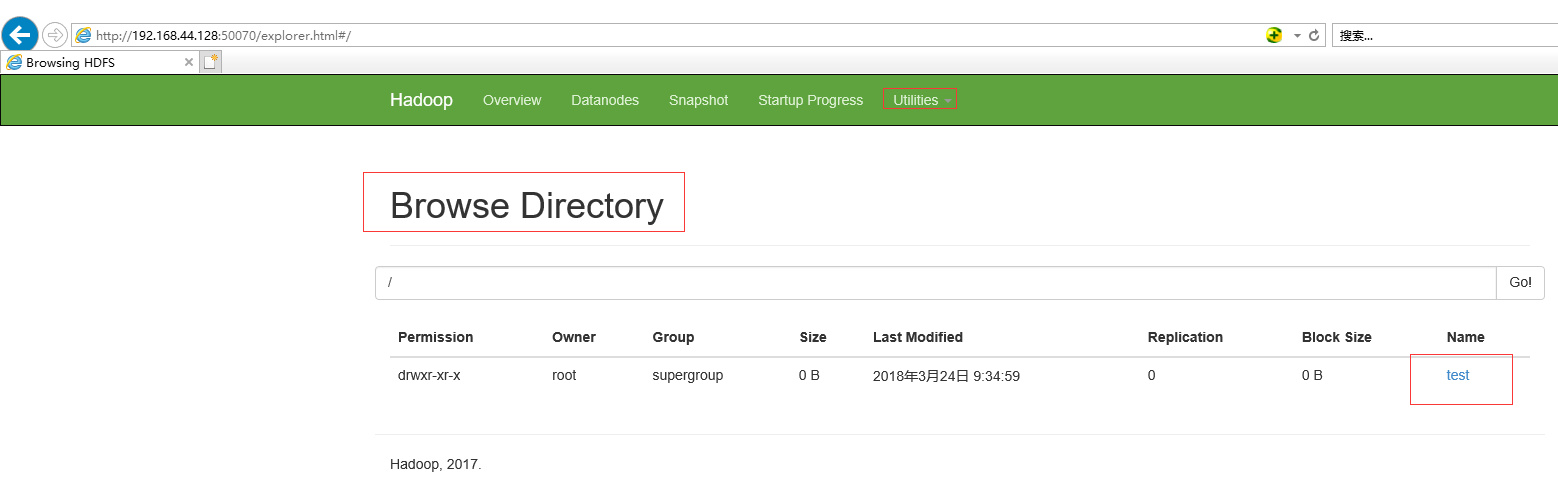

简单的验证hadoop命令:1

hadoop fs -mkdir /test

在浏览器查看,出现如下图所示,即为成功

8、配置yarn

8.1 配置mapred-site.xml

1 | cd /opt/hadoop-2.7.5/etc/hadoop/ |

1 | <configuration> |

8.2 配置yarn-site.xml

1 | vim yarn-site.xml |

1 | <configuration> |

8.3 yarn启动与停止

启动:1

2cd /opt/hadoop-2.7.5

./sbin/start-yarn.sh

1 | ./sbin/stop-yarn.sh |

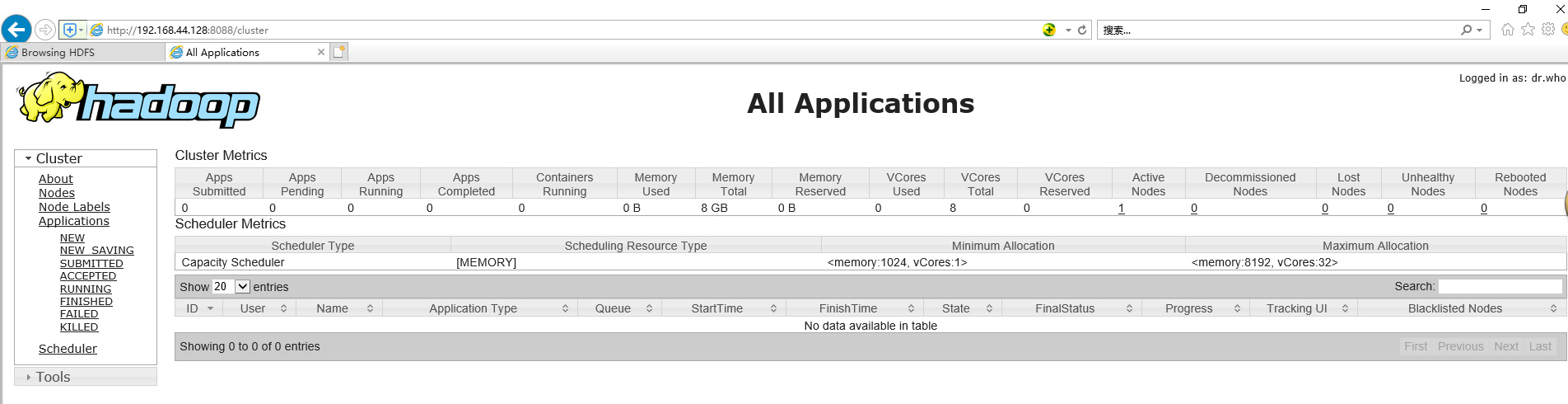

浏览器查看:http://192.168.44.128:8088

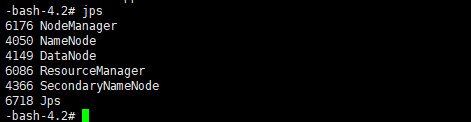

jps查看进程

到此,hadoop单机模式就配置成功了!